Facebook allena l'intelligenza artificiale con la "marijuana" per difendere la privacy

Nel quartier generale londinese, abbiamo incontrato Nicola Bortignon, un giovane ingegnere italiano che vive in perfetto equilibrio tra machine learning e Ai

di Giulio Pinco CaraccioloCome contare le stelle nel firmamento, è un compito praticamente impossibile quello del Community Integrity Team di Facebook. Nella sede di Rathbon Square a Londra, a fianco della celebre Oxford Street, mille ragazzi ogni giorno proteggono la privacy dei 2.45 miliardi di utenti attivi del social network più famoso del mondo. Tra loro anche un giovane ingegnere italiano, Nicola Bortignon. Un passato da Google in California, qualche anno da Spotify in Svezia per poi approdare nel quartier generale londinese di Facebook.

Al terzo piano, tra cartelli motivazionali e aree svago, Bortignon coordina un team di cinquanta persone con l’obiettivo di "migliorare l’intelligenza artificiale permettendole di distinguere qualsiasi tipo di contenuto, interazioni comprese"

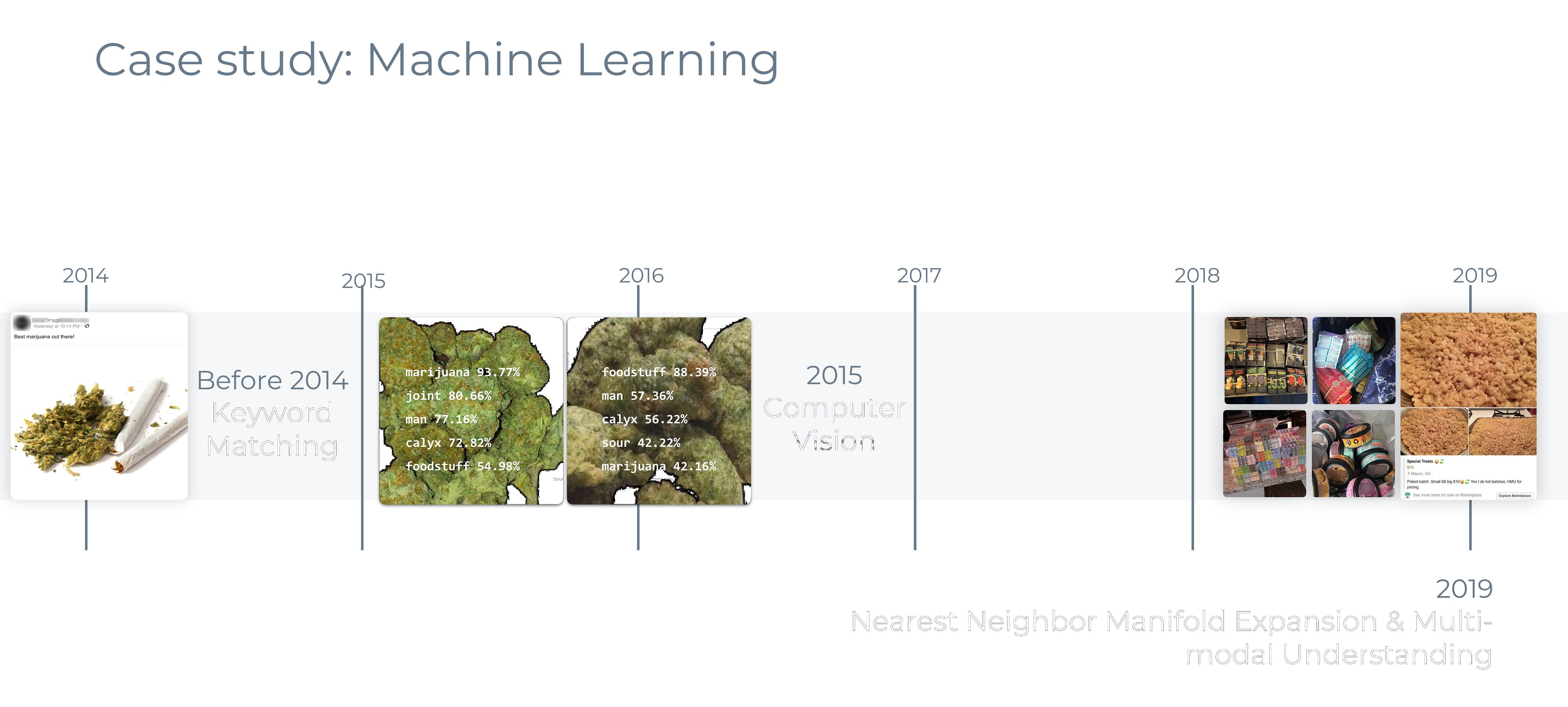

Una mole di dati davvero intensa e a volte gli ingegneri del Community Integrity Team sono costretti ad allenare la macchina con un po’ di marijuana. Si perché gli utenti di Facebook, nel corso degli anni, hanno utilizzato il social per svariati motivi, tra cui la spaccio. Per fermare la vendita di droga, dal 2014 è iniziato un processo di miglioramento dell’intelligenza artificiale. Inizialmente l’algoritmo individuava le parole chiave, poi si è passati al machine learning con immagini di piante di marijuana. Oggi siamo arrivati al punto che tra due foto in primissimo piano e molto simili tra loro, la macchina riesce addirittura a distinguere quale delle due raffiguri i broccoli a vapore.

Ma l’intelligenza artificiale, pur sembrando perfetta, non lo è ancora. Negli anni, non sono mancati errori di censura ingiustificata da parte di Facebook, soprattutto con i nudi nel mondo dell’arte, o come nel caso delle “Sardine”. La pagina del movimento infatti era stata oscurata per alcune ore e poi rimessa online.

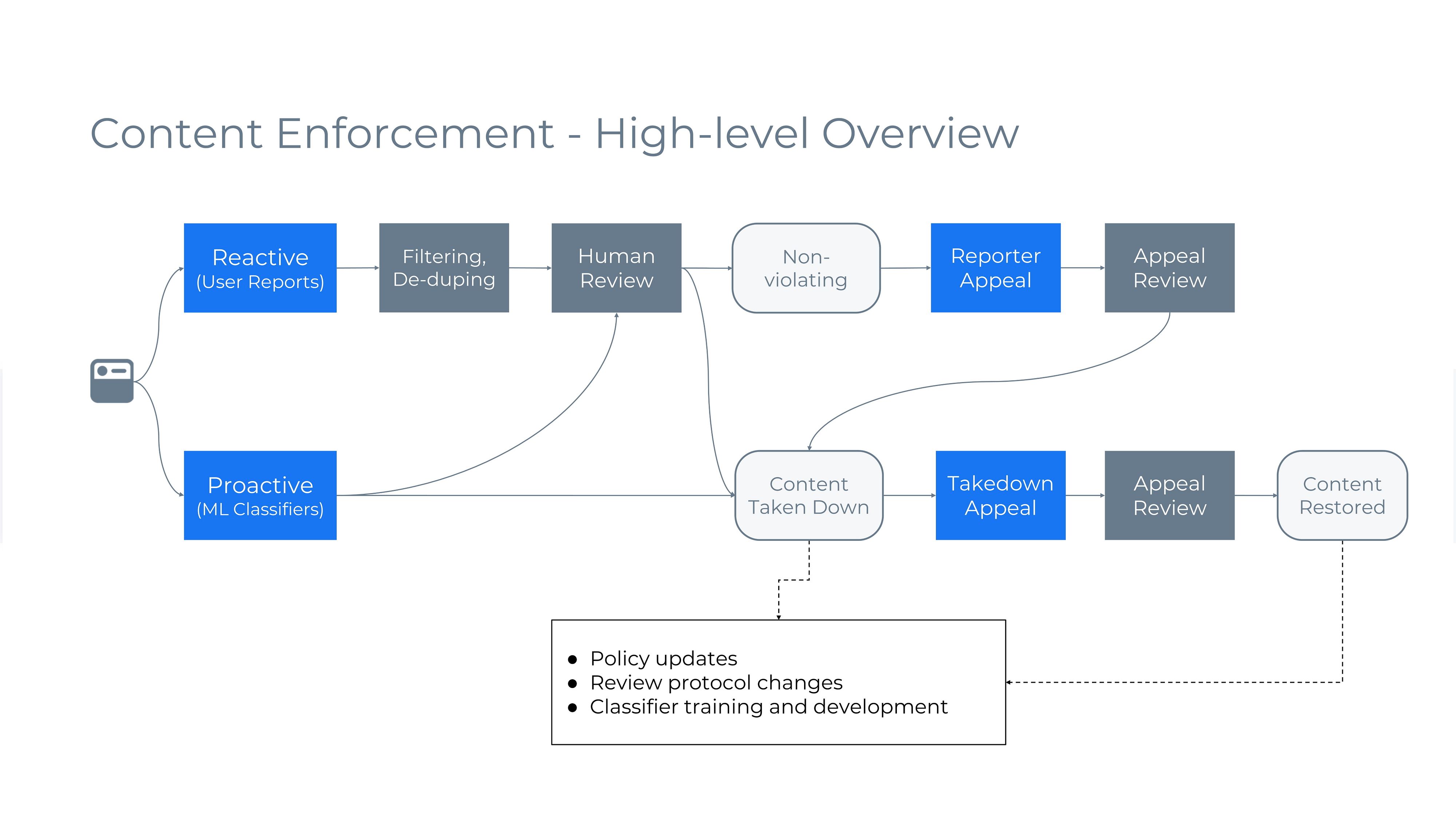

"Offriamo ad ogni utente la possibilità di dirci quando prendiamo la decisione sbagliata - interviene Nicola - il processo delle macchine è automatico e considerando il volume di decisioni che prendono ogni giorno, a volte capita che facciano degli errori. Per questo abbiamo attivato le procedure d’appello contro rimozioni o segnalazioni fatte in violazioni delle community guidelines".

Nel caso di un appello infatti ci sarà un secondo check del contenuto da parte di un moderatore umano. Per ridurre gli errori al minimo, il lavoro viene svolto da tre team che si confrontano tra loro: uno che si occupa di scrivere le regole della community, uno di sviluppare la tecnologia e allenare le macchine che andranno a rimuovere i contenuti in violazione e uno fatto dai revisori umani. Una sinergia perfetta ma sembra che nonostante la tecnologia umana sia sufficiente, la presenza umana per intervenire dove l’intelligenza artificiale non arriva, rimane ancora un aspetto fondamentale.